Migrieren Sie Ihren Shop ohne Ausfallzeiten auf eine leistungsstarke, für Mobilgeräte optimierte Plattform.

Holen Sie sich noch heute einen vollständig individuellen Online-Shop mit einer leistungsstarken API-First-Architektur.

Entwerfen Sie eine Magento-Lösung auf Unternehmensniveau mit Multi-Store- und Drittanbieter-Integrationen.

Optimieren Sie Ihre Geschäftsabläufe, vom Inventar bis zur Buchhaltung, mit einer Xentral ERP-Integration.

Vereinfachen und optimieren Sie noch heute die Unternehmenskaufprozesse für Ihre Geschäftskunden.

Bieten Sie mit einer modernen Headless-Lösung ein blitzschnelles Kundenerlebnis an allen Kontaktpunkten.

Wir sichern Ihre Vermögenswerte mit unternehmensweitem Schutz vor Bedrohungen.

.svg)

Erreichen Sie vollständige Gestaltungsfreiheit mit einer pixelgenauen Webflow-Website. Profitieren Sie von fortschrittlichen Animationen und einfacher CMS-Funktionalität ohne Einschränkungen beim Programmieren.

Verwandeln Sie Ihr Content Management mit einer effizienten WordPress-Lösung in einen leistungsstarken Business-Motor.

Bewältigen Sie komplexe Organisationsstrukturen und Compliance-Anforderungen mit einem TYPO3-System auf Unternehmensebene. Profitieren Sie von fortschrittlichen Content-Workflows und Multi-Site-Management für einen reibungslosen Betrieb.

Modernisieren Sie Ihre digitale Präsenz mit einem professionellen Website-Relaunch. Bewahren Sie alle Ihre Daten und die SEO-Kontinuität und verleihen Sie Ihrer Website gleichzeitig ein frisches, wettbewerbsfähiges Aussehen.

Erweitern Sie die Reichweite Ihres Unternehmens direkt in die Taschen Ihrer Kunden. Erstellen Sie native und plattformübergreifende mobile Apps mit reibungsloser Benutzererfahrung und nahtloser Backend-Integration.

Führen Sie Ihre Kunden mit einem benutzerfreundlichen Online-Shop reibungslos vom Stöbern zum Kauf. Unsere konversionsorientierten Layouts und Einkaufserlebnisse sind darauf ausgelegt, Ihren Umsatz zu steigern.

Unify your sales, inventory, and operations into one integrated system. Deploy a customized Odoo business management suite with automated workflows and module customizations.

Wir sichern Ihre Vermögenswerte mit unternehmensweitem Schutz vor Bedrohungen.

.svg)

Verwirklichen Sie Ihre KI-Ambitionen mit einer Infrastruktur der Enterprise-Klasse, die mit Ihrem Unternehmen mitwächst – ohne komplexe Einrichtung, ohne Ausfallzeiten, ohne Einschränkungen für Ihre Innovationen.

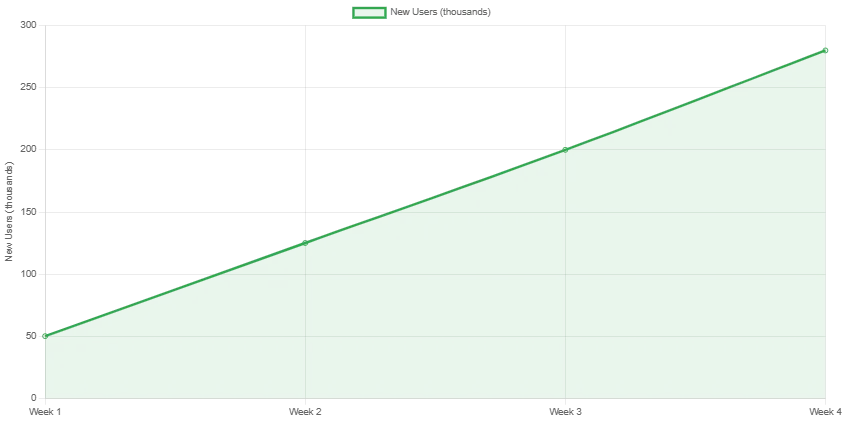

Your business never stops, so why should your workforce? Deepware's AI agents handle your repetitive tasks, analyze complex data, and make smart decisions 24/7 - so your team can focus on what humans do best.

Verbessern Sie die Sichtbarkeit Ihrer Website und ziehen Sie mehr qualifizierte Besucher an. Unser Service macht Ihre Inhalte für Suchmaschinen und KI leicht verständlich und hilft Ihnen so, wahrgenommen zu werden und ein höheres Ranking zu erzielen.

Optimieren Sie Ihre Geschäftsabläufe, indem Sie alle Ihre Apps und Dienste miteinander verbinden. Unser benutzerfreundliches Automatisierungstool schafft nahtlose Arbeitsabläufe und macht Ihr Unternehmen effizienter und produktiver.

Wir sichern Ihre Vermögenswerte mit unternehmensweitem Schutz vor Bedrohungen.

.svg)

Wir schaffen eine starke Stimme für Ihre Marke mit Inhalten, die Ihre Zielgruppe ansprechen. Von der Planung bis zur Umsetzung helfen wir Ihnen, Ihre Geschichte zu erzählen und Leser zu Kunden zu machen.

Verkaufen Sie direkt auf Social-Media-Plattformen. Wir erstellen intelligente Kampagnen, die Ihre Social-Media-Follower zu zahlenden Kunden machen und Ihren Umsatz steigern.

Verbessern Sie das Ranking Ihrer Website in Suchmaschinen, damit mehr Menschen Sie finden können. Unsere Strategien helfen Ihnen dabei, von der richtigen Zielgruppe wahrgenommen zu werden und organischen Traffic auf Ihre Website zu lenken.

Wir helfen Ihnen dabei, die HubSpot-Plattform zu nutzen, um Ihr Geschäft auszubauen. Dank unserer Expertise arbeiten Ihre Marketing-, Vertriebs- und Serviceaktivitäten Hand in Hand.

Wir sichern Ihre Vermögenswerte mit unternehmensweitem Schutz vor Bedrohungen.

.svg)

.svg)

.svg)

.svg)

.svg)

.svg)

.svg)

.webp)

.svg)